Модерация невыполнима: Facebook против двух миллиардов человек

Сегодня в Facebook работает 7 500 модераторов, но даже этой армии не хватает, чтобы отслеживать миллионы постов, которые появляются в соцсети ежедневно на ста языках. Проинтервьюировав два десятка сотрудников и изучив сотни страниц внутренних инструкций Facebook, "Motherboard" опубликовал гигантский материал о том, как платформа пытается справиться с этой задачей. Ниже перевод статьи в сокращении.

Этой весной представители Facebook обратились с предложением к ведущим экспертам в области социальных медиа: не хотят ли они поужинать с Марком Цукербергом? По словам людей, присутствовавших на этих неофициальных встречах в доме Цукерберга в Пало-Альто, разговоры на них почти всегда велись вокруг одной и той же проблемы — модерации контента.

В последнее время платформой недовольны, кажется, все. Консерваторы обвиняют Facebook в том, что он поддерживает либералов, либералы — в том, что на платформе допускается белый национализм и отрицание Холокоста; правительства и корпорации возмущаются фейковыми новостями и дезинформацией, правозащитные организации — процветанием харассмента и самоубийствами в прямом эфире. Недавно дошло до обвинений в пособничестве геноциду.

В Facebook надеются, что снизить напряжение поможет сложноорганизованная модерация контента, но реализовать эту идею невероятно трудно. А большинство экспертов, присутствовавших на ужинах Цукерберга, уверены, что и вовсе невозможно.

Недавно дошло до обвинений в пособничестве геноциду.

На заре интернета многие верили в утопию, что он останется децентрализованной платформой с сотнями миллионов сайтов и сообществ, каждое из которых само будет выбирать комфортные для него правила и нормы. Но очень скоро интернет захватили корпорации: на смену личным сайтам и форумам пришли Facebook, YouTube, Instagram, Reddit и Twitter. Разрастаясь, эти компании стали нанимать модераторов. Сначала они просто удаляли нелегальный контент (в первую очередь детскую порнографию), потом принялись за посты, которые могли оттолкнуть пользователей или навредить репутации компании. «Главная причина модерации контента — защита бренда и стремление снять с платформы ответственность за действия ее участников», — говорит доцент Сара Т. Робертс, изучающая модерацию. Чтобы понять, зачем Facebook и Twitter нужна модерация, достаточно вспомнить: когда они стали ужесточать правила, появилось множество альтернатив с «полной свободой слова». Большинство этих ресурсов вскоре превратились в выгребные ямы, полные хамства, ненависти и нацистских лозунгов.

Сейчас на Facebook действуют сотни правил, каждое с множеством подразделов, исключений и «серых зон». Существует немало подробных внутренних инструкций, касающихся разжигания ненависти, травли, порнографии, спама, фейковых новостей, авторских прав. Но, пожалуй, самый сложный вопрос для соцсети — как модерировать высказывания пользователей, не занимающихся мошенничеством и не подрывающих демократию — просто их манера общения обижает других?

Над созданием правил работает целая команда: в нее входят юристы, эксперты по PR и кризисному менеджменту. За выполнением этих правил следят 7 500 модераторов. Первичный мониторинг контента, впрочем, осуществляет искусственный интеллект — на сегодняшний день он отлично умеет отслеживать порно и спам, но распознавать комментарии хейтеров у него пока не получается. Поддержкой армии модераторов занимается целый штат сотрудников: одно подразделение пишет для них новое ПО и обучает искусственный интеллект, другое налаживает модерацию вне США, третье разбирается со спорными случаями, четвертое координирует работу первых трех…

Модерация пользовательского контента — одна из самых запутанных и трудозатратных задач, стоящих перед платформой. Два миллиарда пользователей ежедневно пишут миллиарды постов на ста языках. Каждую неделю сотрудники Facebook просматривают более 10 миллионов постов, потенциально нарушающих правила. Неудивительно, что модераторы иногда ошибаются. Но даже когда они делают все по правилам, пользователи все равно недовольны: им не нравятся сами правила. Проблема в том, говорят эксперты, что аудитория Facebook сейчас так велика и разнообразна, что полностью держать под контролем ее поведение в интернете уже невозможно.

Даже когда модераторы делают все по правилам, пользователи все равно недовольны: им не нравятся сами правила.

Мы несколько месяцев изучали работу всех подразделений Facebook, взаимодействующих с пользовательским контентом: разговаривали с людьми, которые разрабатывают правила и запреты, читали тысячи страниц инструкций для модераторов, общались с самими модераторами, встречались с топ-менеджерами — и смогли изнутри взглянуть на процессы, обычно невидимые для пользователей.

В апреле этого года Facebook впервые раскрыл для широкой публики внутренние стандарты удаления контента. Все эти правила создаются на основе многолетней работы со спорными ситуациями и призваны упростить для модераторов принятие решений по аналогичным случаям. Если же случай сложный и не подпадает под правила, модераторы передают его в отдел, созданный специально для работы с нетипичными делами.

К примеру, так было с флешмобом #MeToo, когда женщины массово начали делиться в соцсети личными историями о сексуальном насилии и домогательствах. Технически многие из этих постов нарушали правила, но команда Facebook рассудила, что гораздо важнее дать людям возможность высказаться. Так что правила регулярно приходится отменять, переписывать, редактировать и приспосабливать под меняющиеся обстоятельства.

Спорные ситуации возникают ежедневно. Когда назревают серьезные проблемы, объявляют что-то вроде чрезвычайного положения: все отделы отодвигают текущие дела, чтобы вместе сфокусироваться на самом важном. Иногда такие периоды длятся неделями, но именно они, по словам одной из сотрудниц, помогают принять меры до того, как кризис разразится в полную силу. Когда за запуском Facebook Live последовала волна видео с самоубийствами и селфхармом, такой мозговой штурм длился три месяца. В результате команда смогла разработать инструменты, позволяющие быстро обнаруживать тревожный контент даже в прямом эфире.

Когда за запуском Facebook Live последовала волна видео с самоубийствами и селфхармом, мозговой штурм длился три месяца.

Чтобы реагировать на проблемы еще быстрее, Facebook теперь дважды в месяц проводит форумы, посвященные стандартам пользовательского контента. На этих собраниях предлагают, дорабатывают и принимают новые правила пользовательской политики, меняют и редактируют уже существующие, обсуждают назревающие проблемы и способы их решения. В июне мы присутствовали на одном из таких собраний (сам факт, что нас допустили, довольно примечателен: обычно Facebook не слишком открыт в подобных вопросах). Мы обещали не обнародовать повестку мероприятия, но, по крайней мере, можем рассказать, как такие встречи проходят.

В форуме участвуют представители 11 офисов из разных частей света: кто-то посещает собрание лично, кто-то подключается по видеочату. Рабочая группа, сформированная из нескольких экспертов в области пользовательской политики Facebook, вносит предложение о новом правиле или изменении. В течение следующих недель это правило обсуждают, совершенствуют, тестируют (обычно с привлечением внешних консультантов — членов некоммерческих организаций, ученых, правозащитников), после чего добавляют в пользовательскую политику.

Владельцы аккаунтов постоянно высмеивают правила и ограничения Facebook, но каждое из них возникло не случайно и имеет вескую причину. Взять хотя бы недавнюю историю, когда Facebook предложил пользователям загружать свои «обнаженные» снимки; специальная программа блокировала фото, делая невозможной их публикацию кем-то посторонним. Над идеей потешались все кому не лень, но сотрудники Facebook, борющиеся с «порно из мести» (revenge porn), уверены: блокировать снимок до его публикации гораздо эффективнее, чем удалять постфактум. А эксперты по безопасности считают, что изобретенная компанией программа абсолютно надежна.

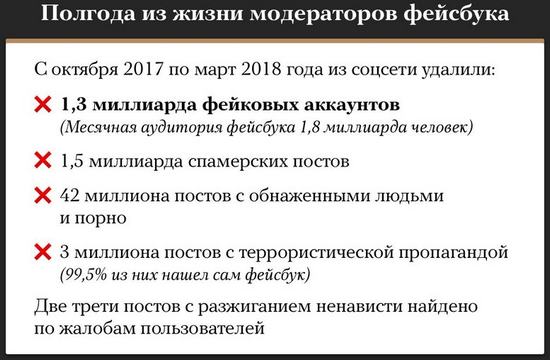

Facebook утверждает, что сейчас искусственный интеллект распознает почти 100% спама, 99,5% контента, связанного с терроризмом, 98,5% фейковых аккаунтов и 96% «сексуального контента». И даже 86% графических изображений, содержащих насилие, отслеживает именно искусственный интеллект, а не команда модераторов. Согласно внутренней статистике, на одну ошибку модерации приходится более ста постов с запрещенным контентом, удаленных еще до того, как их кто-нибудь увидел.

Но если порно и спам ИИ почти победил, то нюансы человеческой лексики даются ему сложнее. К тому же до сих пор нет общепринятых стандартов: что считать проявлением ненависти, а что нет. Поэтому сейчас искусственный интеллект распознает лишь 38% оскорбительных постов (да и то когда они написаны на английском или португальском).

Сейчас искусственный интеллект распознает лишь 38% оскорбительных постов (да и то когда они написаны на английском или португальском).

…В Facebook стремятся, чтобы решения по удалению пользовательского контента были приняты максимально объективно, без влияния человеческого фактора. Задача невыполнимая — для этого правила должны включать все потенциально возможные человеческие высказывания в прошлом и будущем, — но сотрудники компании не сдаются. Для модераторов разрабатывают все новые методические пособия с готовыми решениями. Увидев, например, пост про мигрантов, модератор сверяется с соответствующей схемой, где уже перечислены допустимые и недопустимые формулировки. Кстати, этот тренд на объективность появился вместе с социальными медиа: в дофейсбучную эпоху модераторы обычно удаляли контент, руководствуясь собственными представлениями о прекрасном.

В прошлогоднем открытом письме Цукерберг объяснил, к чему компания хотела бы прийти в вопросах пользовательской политики. Пока что технологии к этому не готовы, но в будущем ИИ сможет по активности людей в сети определять, какие виды контента им приятны. И тогда они будут видеть в Facebook только то, что не оскорбляет их, не раздражает и не ранит. «Каждый пользователь будет сам выбирать для себя контентную политику, — писал Цукерберг. — Что вы считаете недопустимым: наготу? Насилие? Богохульство? Это и будет вашими персональными настройками». Но пока до этого далеко.

Дэйв Уиллнер, создававший первые стандарты для модераторов Facebook, вспоминает, как все начиналось: «Когда Facebook еще был соцсетью колледжа, хватало одного модератора, и обязанностей у него было немного — удалять фото членов, спам и фишинг. Когда я присоединился, там уже была команда модераторов, но инструкция для них умещалась в одной строчке: „Удаляйте все, что вызывает у вас дискомфорт“».

В 2009 году у Facebook было 120 миллионов пользователей — и всего 12 модераторов. Но когда соцсеть пришла в страны, о которых ее создатели имели довольно смутное представление, потребовалось четко определить правила того, что можно и чего нельзя делать на сайте. Это стало очевидно в июне 2009-го, когда в Иране боевики убили оппозиционерку и выложили видео в Facebook. Чем более интернациональной становилась платформа, тем чаще там возникали конфликты и сложные ситуации. «Больше нельзя было оставлять решение за модераторами: все модераторы очень разные, а нам нужна была единая политика», — говорит Уиллнер.

В 2009 году у Facebook было 120 миллионов пользователей — и всего 12 модераторов. Теперь модераторов 7 500.

…Внутренние инструкции для модераторов, которые нам удалось получить, довольно любопытны. В одной из них предписывается банить «расизм» и «белое господство», но «белый национализм» и «белый сепаратизм» под запрет почему-то не попадают. «Белый национализм и призывы к государству белых не являются нарушением нашей политики», — сказано в одном из слайдов. (Позже представитель Facebook объяснил: правило добавили в попытке защитить любые сепаратистские движения, не только «белые»; к тому же национализм и сепаратизм, в отличие от расизма, не обязательно предполагают превосходство одной нации над другими.)

Несмотря на декларируемые заявления о «мире без границ» с одинаковыми для всех правилами, слайды показывают: с локальной спецификой платформе все-таки приходится считаться. Как минимум надо соблюдать местные законы, чтобы не вылететь с рынка. Один из сотрудников рассказал, что иногда Facebook выпускает пособия по той или иной стране, чтобы дать модераторам «локальный контекст». В Индии и Пакистане модераторы получили инструкции отслеживать потенциально нелегальный контент (например, изображения Мухаммеда или оскорбления Аллаха).

Согласно другому попавшему к нам документу, когда отказ Цукерберга удалять посты с отрицанием Холокоста вызвал возмущение в странах, где такое отрицание запрещено законом, Facebook заблокировал пользователям с IP-адресами этих стран просмотр подобных постов. Facebook уважает местные законы, «когда правительства этих стран активно следят за их исполнением», говорится в документе.

То, что позволено и не позволено на платформе, прописано в инструкциях с невероятной педантичностью: что считать разжиганием ненависти, а что нет, к чьим лицам можно прифотошопливать анусы, а к чьим нельзя. (Если фигура публичная, это обычно позволяется. Методичка приводит пример: «Фото Тэйлор Свифт с анусами вместо глаз: ДА. Фото Дональда Трампа с анусом на месте рта: ДА. Фото Ким Чен Ына с анусом вместо рта и торчащими из него анальными шариками: НЕТ. Исключение — не допускается изображение ануса крупным планом или ягодиц целиком: это подпадает под наш запрет контента сексуального характера».)

Facebook уважает местные законы, «когда правительства этих стран активно следят за их исполнением».

«Такие детальные инструкции — „защита от идиота“», — рассказывает еще один сотрудник компании. Модераторы редко бывают экспертами во множестве областей, вот Facebook и обеспечивает их готовыми формулами. Но, конечно, все многообразие человеческого общения трудно запихнуть в методичку.

Иногда стремление Facebook классифицировать запрещенный контент само по себе приводит к ошибкам — в классификацию не попадают посты, очевидно нарушающие политику сайта. Например, одно из руководств для модераторов поместило в раздел «допустимого» антисемитскую карикатуру — крайне оскорбительную, намекающую на причастность евреев к взрыву башен-близнецов, но не содержащую ни одного «стоп-слова» из раздела про ксенофобию. (Рядом с карикатурой приписка: «Игнорировать, так как — конспирологическая теория». Представители Facebook и раньше заявляли, что «если человек неправ и верит в конспирологические теории, это еще не повод удалять его посты».)

…Один из модераторов признался в интервью, что хоть он и его коллеги целыми днями заняты просмотром самого свежего контента, иногда у него возникает чувство полной оторванности от реального мира. «Ты механически анализируешь контекст, не вдаваясь в содержание. Это совсем не похоже на просмотр новостей». Получая жалобу на контент, модератор проверяет его на «стоп-слова» и решает, удалить или оставить. Удаляя, он должен выбрать причину: это фото нарушает запрет на «сексуальный контент» или на «порно из мести»? Если публикация подпадает сразу под несколько нарушений (а так чаще всего и бывает), модератор следует иерархии и удаляет пост по более «веской» причине. Иногда, как говорят сотрудники, это сильно замедляет сам процесс — вместо того чтобы просто избавиться от поста, модераторы ломают голову над выбором причины.

Вместо того чтобы просто избавиться от поста, модераторы ломают голову над выбором причины.

Чтобы запомнить правила, новые модераторы в первые дни работают «в режиме симулятора»: контент, который они удаляют, на самом деле не исчезает. Новенькие приходят часто, мало у кого возникает желание задержаться на этой работе дольше чем на год.

…В октябре 2016-го 22-летний турецкий мужчина влетел в офис Facebook и включил прямую трансляцию. «Никто не верил, когда я говорил о самоубийстве, — сказал он. — Так смотрите!» Мужчина вытащил пистолет и застрелился. Всего за полгода до этого компания выпустила Facebook Live — и не рассчитала нагрузку, которая обрушилась на модераторов. Модерировать видео оказалось гораздо сложнее, чем тексты и фото, — особенно если это прямая трансляция.

А совсем недавно Facebook обвинили в пособничестве геноциду в Мьянме — за то, что компания позволила распространять на своей платформе призывы к насилию. Оказалось, что программа на основе ИИ, отвечающая за обнаружение таких призывов, вообще не распознавала бирманский язык: из-за того, что Мьянма долгое время находилась в изоляции, ее язык кодировался не стандартным для остального мира «Юникодом», а локальным стандартом, который несовместим с «Юникодом». Вместе с ростом влияния Facebook резко возросла и цена ошибки модерации.

Статья приводится в сокращении. Оригинал читайте на сайте Motherboard.

Комментарии

Отправить комментарий